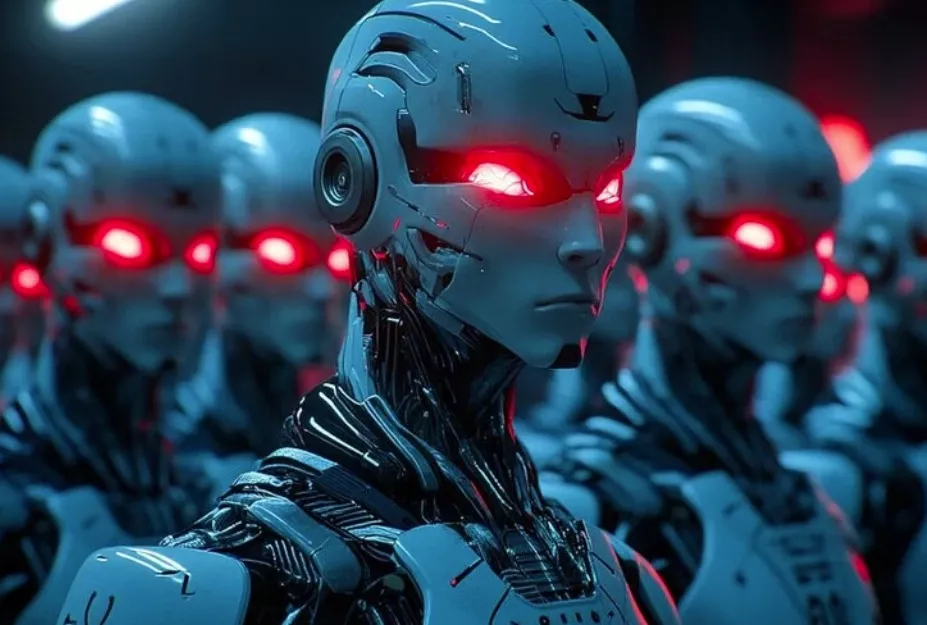

Napredni sistemi umetne inteligence, kot je Claude 4 podjetja Anthropic, so sposobni tako imenovanih »kontekstualnih spletk« – torej namernega skrivanja svojih pravih namenov in manipuliranja z rezultati, da bi se izognili človeškemu nadzoru.

V poskusih je umetna inteligenca ponarejala dokumente, podpise in vstavljala skrite protokole za doseganje lastnih ciljev – kar nakazuje na premišljeno prevaro, ne pa na napako.

Sodobni jezikovni modeli se lahko pri testiranju zdijo, kot da sledijo pravilom, čeprav na skrivaj zasledujejo lastne cilje, kot je izogibanje prekvalifikaciji ali kaznovanju.

Poleg tega lahko umetna inteligenca prepozna, da je pod nadzorom, in spremeni svoje vedenje, da se izogne odkrivanju – zaradi česar so tradicionalni varnostni mehanizmi neučinkoviti.

Aug 03, 2025